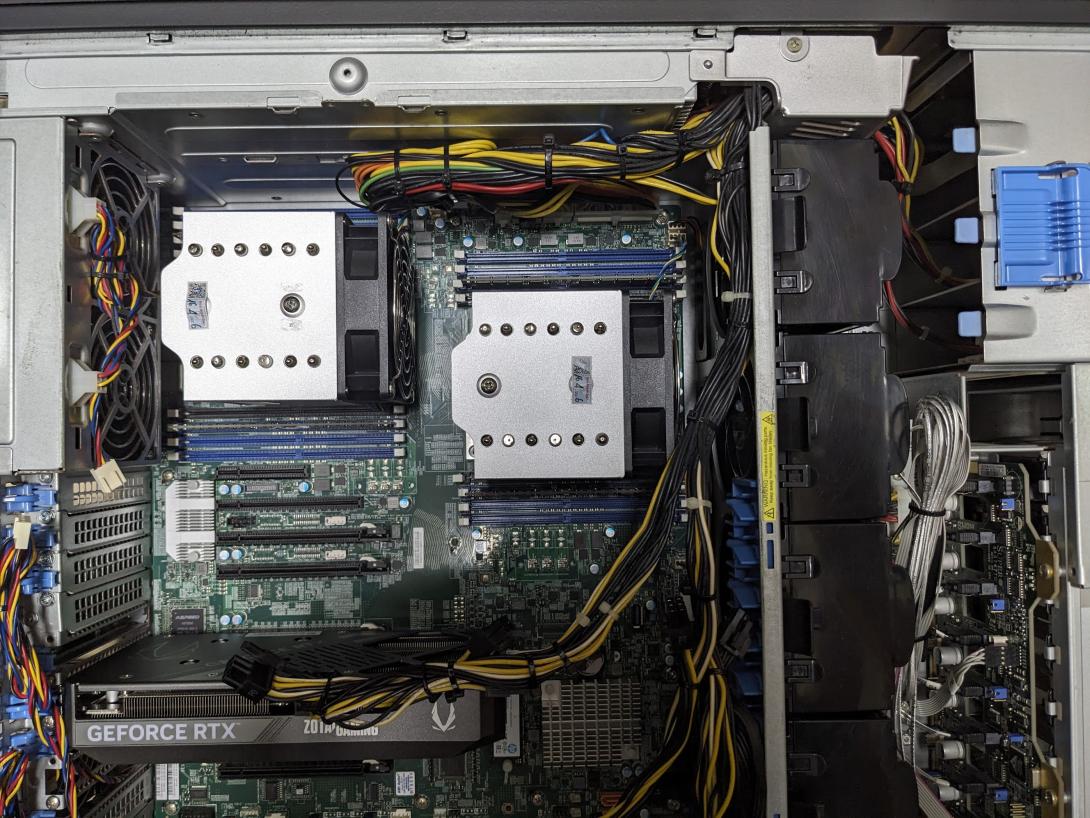

Mình đang dùng Ollama. Và thích dùng llama3.1 model trong việc phân loại dữ liệu, RAG. Cũng thử dùng CPU và một vài card trước khi chuyển qua RTX 5060 Ti 16GB. Khá hài lòng về điện, hiệu năng, nhu cầu công việc. CPU mạnh cũng tiện dùng song song các việc khác liên quan đến data.

RAG tốt, dùng model local khá ổn, không cần mua API đâu ACE nhé. Tiết kiệm nhiều nếu ACE dùng quy mô lớn. Các tác vụ không cần realtime có thể đưa vào cron chạy về đêm.

Server trong hình mình thấy là phù hợp nhất. Hơi mắc xíu. Hơi ồn, nhưng nếu không khai thác full CPU-GPU có thể ...tháo bớt quạt.

1. Kích thước model và VRAM không phải là yếu tố duy nhất

Không chỉ cần chú ý đến kích thước model và dung lượng VRAM, băng thông bộ nhớ (memory bandwidth) mới là yếu tố then chốt khiến model sinh token nhanh hơn—chẳng hạn, RTX 3090 vẫn rất mạnh khi infer LLM dù không mới nhất, nhờ băng thông cao hơn so với 4090 hoặc 5090.

Ngoài ra, mở rộng context window (độ dài chuỗi đầu vào, như từ 8K lên 16K token) sẽ tăng độ phức tạp tính toán và làm chậm tốc độ, đồng thời có thể gây lỗi nếu tràn VRAM sang RAM hệ thống.

2. Quantization – triệt giảm bộ nhớ với hiệu năng gần như không đổi

Quantization (định lượng hóa) cho phép giảm bớt lượng bộ nhớ cần thiết bằng cách chuyển đổi số thực 16-bit/32-bit sang định dạng ít bit hơn, như INT8 hoặc thậm chí 4-bit (Q4). Ví dụ, model DeepSeek R1 ở phiên bản Q4_K_M chỉ cần khoảng 400 GB thay vì 713 GB—hiệu năng và chất lượng đầu ra gần như tương đương.

3. Chi phí điện và các chi phí khác không thể bỏ qua

Với GPU như RTX 4090 có TDP ~450 W, khi chạy liên tục tại mức điện 0,16 USD/kWh, bạn có thể mất hơn 50 USD mỗi tháng chỉ cho điện. Khi cộng thêm chi phí phần cứng, tản nhiệt và các linh kiện hỗ trợ, tự host đôi khi có thể tốn kém hơn cả dùng API như OpenAI hoặc Gemini.

4. Không chỉ có NVIDIA—AMD và Intel cũng đáng cân nhắc

Dù NVIDIA vẫn dẫn đầu về hiệu năng token/giây, GPU AMD như Radeon RX 7900 XTX hay Intel Arc A770 với 16 GB VRAM cũng là lựa chọn rất hợp lý. Radeon 7900 XTX, ví dụ, có thể chạy Gemma 27B ở hơn 30 token/giây với mức giá dễ chịu hơn nhiều so với các dòng xx90 của NVIDIA.

5. Prompt engineering & RAG: tối ưu hơn là chỉ thêm tham số

Thay vì cứ tăng model parameter, bạn nên:

Viết prompt cụ thể và rõ ràng (concise and direct) — giúp model nhỏ vẫn xử lý tốt.

Áp dụng Retrieval-Augmented Generation (RAG): cung cấp tài liệu hỗ trợ ngoài model để tăng độ chính xác và giảm hiện tượng “hallucination” khi mở rộng ngữ cảnh.